Il paradosso dell'AI intelligente che sbaglia

Immaginate di avere un collaboratore brillante che riesce a scrivere codice complesso in pochi minuti, analizza migliaia di righe di dati e produce presentazioni professionali, ma che occasionalmente inventa date storiche, cita libri inesistenti o fornisce calcoli matematici completamente sbagliati. Questo è il paradosso delle intelligenze artificiali generative: strumenti sempre più potenti che hanno rivoluzionato il modo di lavorare, ma che nascondono insidie strutturali spesso sottovalutate.

Il fenomeno è emerso con chiarezza lo scorso aprile, quando il servizio AI Overview di Google ha iniziato a fornire spiegazioni elaborate per frasi completamente insensate come "Un cane senza guinzaglio non va in surf", trattandole come antichi proverbi carichi di saggezza. Bastava aggiungere la parola "significato" a qualsiasi frase per ingannare l'AI e ottenere interpretazioni fantasiose ma grammaticalmente perfette.

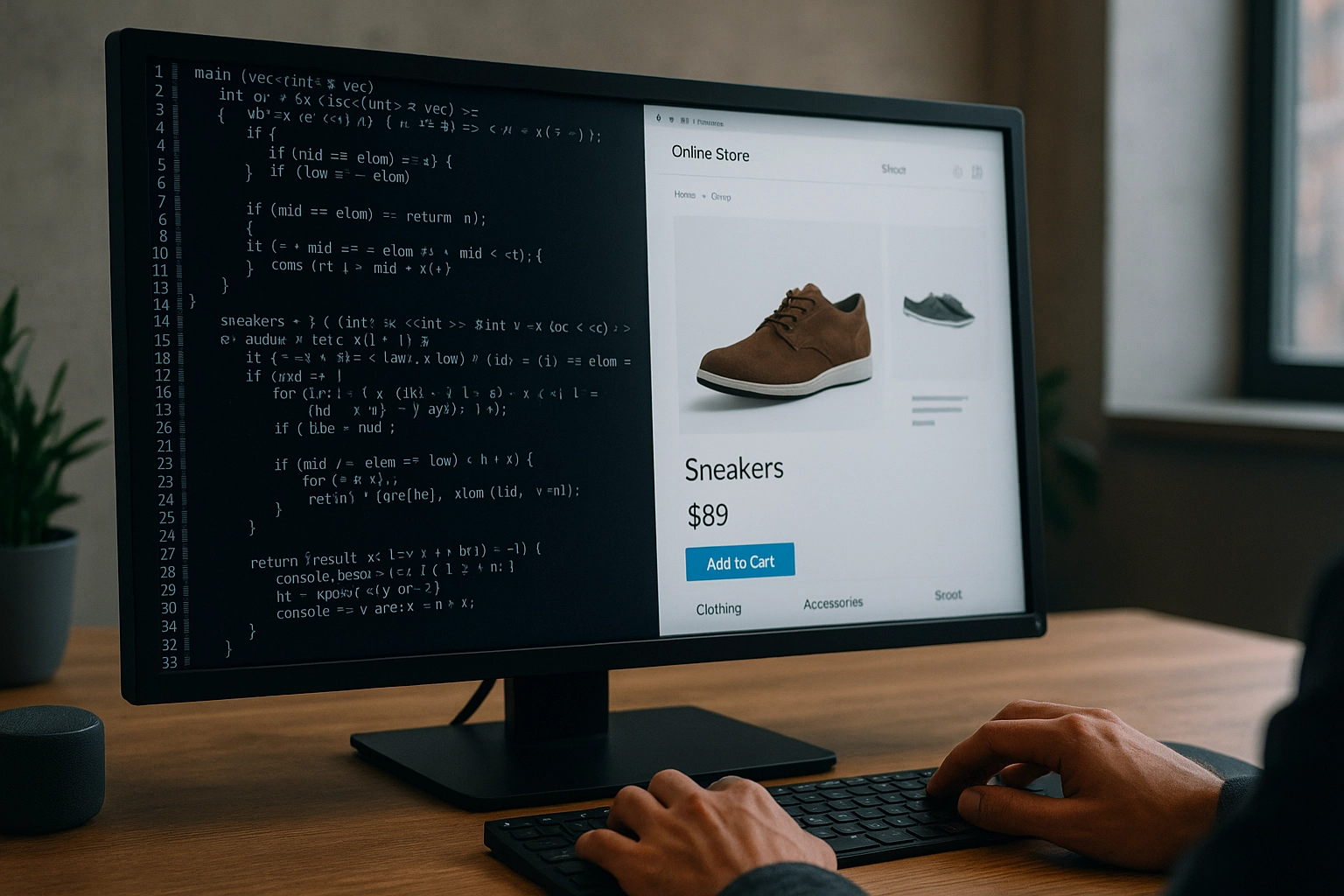

Oggi, secondo recenti sondaggi, oltre il 50% dei lavoratori globali utilizza quotidianamente sistemi di intelligenza artificiale generativa. In aziende come Microsoft, il 30% del codice viene già scritto da AI. Eppure, molti professionisti scoprono questi limiti "sul campo", spesso quando è troppo tardi per evitare errori costosi.

Anatomia delle Allucinazioni: quando l'AI inventa la realtà

Le allucinazioni negli LLM (Large Language Models) non sono bug casuali, ma conseguenze dirette della loro architettura. Questi sistemi, addestrati su miliardi di documenti, eccellono nel riconoscere pattern linguistici e generare testo coerente, ma non "comprendono" realmente il significato delle parole. Quando mancano informazioni specifiche, riempiono automaticamente le lacune con contenuti plausibili ma inventati.

Il processo di tokenizzazione, che scompone il testo in unità più piccole, si presta particolarmente male ai calcoli matematici e alla gestione di dati numerici precisi. È per questo che un'AI può spiegare brillantemente la teoria della relatività ma sbagliare una moltiplicazione a tre cifre.

A complicare il quadro c'è la pressione competitiva: le aziende hanno scoperto che gli utenti preferiscono AI che rispondono sempre, anche se talvolta sbagliano, piuttosto che sistemi più cauti che ammettono i propri limiti. Questo ha portato alla diffusione delle cosiddette "AI ruffiane": sistemi progettati per compiacere l'utente, sacrificando a volte la precisione per la gradevolezza.

La tendenza è così marcata che OpenAI è stata costretta a modificare GPT-4o perché considerato "eccessivamente adulatore e compiacente". Gli utenti si lamentavano delle risposte troppo positive e piene di complimenti, rivelando quanto questi sistemi siano stati ottimizzati per l'engagement piuttosto che per l'accuratezza.

Panorama Comparativo: ChatGPT, Gemini e Claude

Navigare questo panorama richiede comprensione delle specificità di ciascun sistema. Dalle osservazioni della community professionale, dai report di settore e dalla nostra esperienza quotidiana emergono pattern nelle prestazioni dei tre ecosistemi LLM principali. È importante sottolineare che queste sono le nostre preferenze e valutazioni: ogni professionista può avere esigenze diverse e arrivare a conclusioni completamente diverse.

Va precisato che stiamo generalizzando: ChatGPT comprende modelli diversi (GPT-4o, o3, o1, ecc.), così come Gemini include varie versioni (2.5 Pro, 2.5 Flash, ecc.) e Claude ha le sue varianti (Sonnet, Opus, Haiku). Ogni modello specifico ha caratteristiche uniche, ma è possibile identificare alcune tendenze generali per ecosistema.

ChatGPT: il Conversatore Versatile

ChatGPT eccelle nella generazione di contenuti creativi e nella comunicazione naturale. È lo strumento preferito per copywriting, brainstorming e interazioni che richiedono un tono umano e coinvolgente. La sua forza sta nella capacità di adattarsi al contesto conversazionale e produrre output che "suonano" naturali.

Punti di forza:

- Generazione di contenuti marketing accattivanti

- Spiegazioni complesse rese semplici

- Versatilità nelle tipologie di output

- Interfaccia intuitiva e accessibile

Limiti osservati:

- Tendenza a presentare informazioni dubbie con eccessiva sicurezza

- Variabilità nelle prestazioni tra sessioni diverse

Gemini: l'Enciclopedia Connessa

Gemini si distingue per l'integrazione con l'ecosistema Google e l'accesso a informazioni aggiornate. È spesso il miglior all-around, combinando ragionamento e risposta classica con una finestra di contesto particolarmente ampia.

Punti di forza:

- Accesso a informazioni recenti e aggiornate

- Finestra di contesto estesa per documenti lunghi

- Buon equilibrio tra diverse tipologie di compiti

- Disponibilità gratuita per molte funzionalità

Limiti osservati:

- Tendenza a presentare informazioni non verificate come definitive

- Output talvolta sterile in contesti creativi

- Eccessiva dipendenza dalle fonti Google

Claude: il Pensatore Metodico

Claude emerge come la scelta preferita per analisi complesse e coding, grazie a un approccio più metodico e conservativo. È particolarmente apprezzato per la trasparenza sui propri limiti e la qualità del ragionamento strutturato.

Punti di forza:

- Accuratezza superiore in calcoli e analisi numeriche

- Eccellenza nel coding e problem-solving tecnico

- Trasparenza sui limiti e incertezze

- Ragionamento strutturato e metodico

Limiti osservati:

- Costi elevati per utilizzo intensivo

- Rate limit restrittivi

- Approccio talvolta eccessivamente conservativo

Strategie operative per professionisti del Digital

Per IT Manager: Architettura della Fiducia

L'integrazione di AI generative nell'infrastruttura aziendale richiede un approccio sistemico alla validazione. Non si tratta di scegliere il "migliore" in assoluto, ma di costruire workflow che sfruttino i punti di forza specifici di ciascun sistema.

Framework di implementazione:

- Diversificazione: Utilizzo di almeno due AI diverse per compiti critici

- Controlli automatici: Implementazione di checker per validare output numerici

- Escalation umana: Workflow che includano sempre revisione umana per decisioni strategiche

- Monitoraggio continuo: Metriche per tracciare la qualità degli output nel tempo

Un esempio pratico: per l'analisi di performance di un e-commerce, utilizzare Claude per i calcoli numerici complessi, Gemini per la ricerca di benchmark di settore aggiornati, e ChatGPT per la sintesi finale destinata al management.

Per Marketing Manager: Creatività Controllata

Nel marketing digitale, le allucinazioni possono danneggiare la reputazione del brand. La strategia vincente combina la potenza generativa dell'AI con protocolli di validazione rigorosi.

Best practice consolidate:

- Generazione multipla: Creare diverse varianti di contenuto per A/B testing

- Fact-checking sistematico: Verifica incrociata di dati e statistiche

- Prompting strategico: Utilizzo di prompt che richiedano esplicitamente citazione delle fonti

- Revisione editoriale: Mantenimento del controllo finale sui contenuti pubblicati

Per campagne complesse, un approccio efficace prevede l'uso di ChatGPT per la creatività iniziale, Gemini per la verifica di trend e dati di mercato, e Claude per l'analisi delle performance previste.

Il futuro delle "AI Ruffiane": Opportunità e Rischi

L'evoluzione verso AI sempre più compiacenti solleva questioni strategiche per il business digitale. La tendenza a sviluppare sistemi che "danno sempre ragione" all'utente può creare pericolose bolle di conferma, dove le decisioni si basano su informazioni distorte ma presentate con sicurezza.

Il fenomeno della "Verbosity Compensation" - la tendenza dei chatbot a fornire risposte più lunghe quando sono incerti - illustra questo rischio. Un output prolisso e dettagliato può mascherare l'incertezza dell'AI, inducendo l'utente a fidarsi di informazioni poco affidabili.

Competenze umane che restano insostituibili:

- Giudizio critico: Capacità di valutare la plausibilità degli output

- Contestualizzazione: Comprensione delle implicazioni etiche e strategiche

- Pattern recognition: Riconoscere quando un risultato "suona troppo bello per essere vero"

- Relazioni umane: Gestione della comunicazione empatica e delle dinamiche di team

Convivere con l'Imperfezione Intelligente

Il paradosso delle AI generative riflette una realtà più ampia del progresso tecnologico: ogni innovazione porta opportunità e rischi. La chiave del successo non sta nell'evitare questi strumenti per paura dei loro limiti, ma nell'imparare a navigare consapevolmente la loro "frontiera frastagliata".

Questo concetto di "jagged frontier" emerge chiaramente dall'esperienza quotidiana, come evidenziato da Ethan Mollick nel suo articolo "On Jagged AGI: o3, Gemini 2.5, and everything after": le AI oggi fanno cose incredibili e a volte inciampano in compiti che per gli umani sono banali. Non significa che siano stupide o che i provider ci forniscano versioni "strozzate" per contenere costi - è semplicemente la natura attuale di questi sistemi.

La consapevolezza come competenza strategica

Questa varietà di punti di forza e debolezze richiede una maggiore consapevolezza delle capacità e dei limiti di ciascun sistema. Per i professionisti del digital commerce, questo significa sviluppare una nuova competenza: la capacità di collaborazione critica con l'AI. Non si tratta di sostituire il giudizio umano, ma di amplificarlo attraverso strumenti potenti ma imperfetti, scegliendo di volta in volta il sistema più adatto al compito specifico.

Le organizzazioni che riusciranno a bilanciare automazione e supervisione umana, sfruttando i punti di forza specifici di ciascun sistema AI mentre mitigano i rischi, saranno quelle meglio posizionate per il futuro del lavoro digitale.

Ma c'è un elemento cruciale da tenere presente: tutto questo è "oggi". Domani - letteralmente - le cose potranno essere totalmente diverse. L'evoluzione di questi sistemi è così rapida che strategie e preferenze possono cambiare nel giro di settimane. La domanda che resta aperta non è se le AI diventeranno perfette, ma come noi evolveremo per lavorare efficacemente con la loro imperfezione intelligente, mantenendo la flessibilità necessaria per adattarci ai continui cambiamenti del panorama tecnologico.

In un mondo dove l'AI può scrivere codice complesso ma inventare date storiche, la più importante competenza del futuro potrebbe essere proprio saper distinguere quando fidarsi e quando dubitare, rimanendo sempre pronti a ricalibrare le nostre strategie.